SAP IS - Cloud Integration

Flujo de integración: Data Store Operations: Write

Contenido

Contenido

1. Cloud Integration

SAP Cloud Integration favorece la integración de procesos comerciales que comprende diferentes empresas, organizaciones o departamentos dentro de una organización.

SAP Cloud Integration le facilita al usuario la conexión de aplicación locales y en la nube con otras aplicaciones existentes locales y en la nube de SAP ya que este tipo de servicio procesa los mensajes en escenarios en tiempo real que abarcan diferentes empresas, organizaciones o departamentos dentro de una organización.

2. Flujo de Integración

Un flujo de integración es la base de cualquier proyecto de integración de datos ya que contiene funciones de automatización integradas que hacen que este proceso sea tan fácil que los usuarios comerciales no técnicos puedan crear flujos con el soporte de TI mínimo o nulo.

3. Data Store Operations

Este es uno de los elementos de persistencia que encontramos en la barra de herramienta que nos permite almacenar datos de un flujo de integración para ser usados en pasos posteriores del mismo flujo. En el Data Store Operations encontramos cuatro operadores que podemos resumir así:

- Delete: Nos permite eliminar una entrada existente del almacenamiento de datos.

- Get: Nos permite obtener una entrada concreta del almacenamiento de datos mediante un ID.

- Select: Nos permite seleccionar múltiples entradas del almacenamiento de datos.

- Write: Nos permite crear una entrada en almacenamiento de datos. Si este no existe, lo crea.

Para el desarrollo de este artículo vamos a usar la Write para escribir uno o varios mensajes en el almacenamiento de datos.

4. Desarrollo

En este articulo plantearemos el escenario donde crearemos un almacenamiento de datos y enviaremos un mensaje mediante un modificador de contenido el cuál será guardado en dicho almacenamiento.

Requisitos

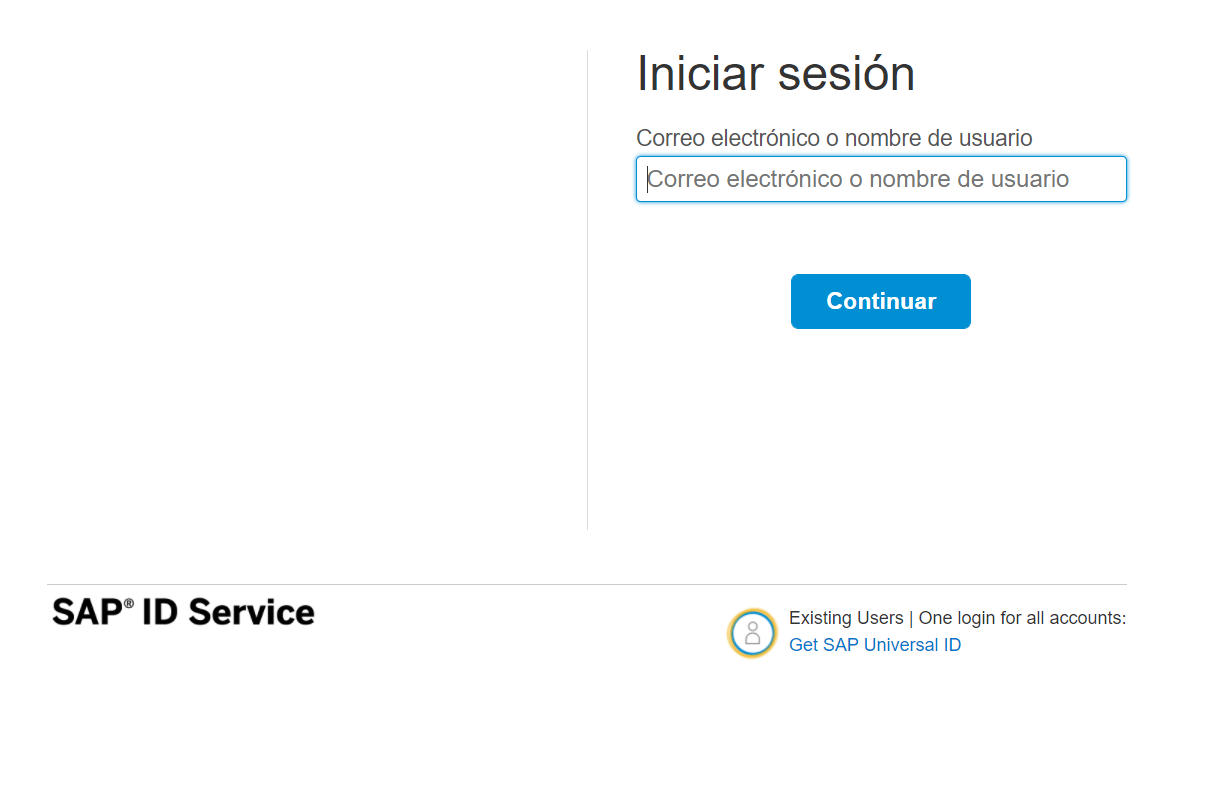

Hay que tener en cuenta que para poder realizar este ejercicio se debe contar con una cuenta en SAP BTP Cockpit y con la suscripción de Integration Suite, tener un paquete de integración creado en la plataforma de Cloud Integration y contar con credenciales de usuario para conexión a correo electrónico. Primero se debe acceder a un navegador e ingresar la siguiente URL https://account.hanatrial.ondemand.com para ingresar a nuestra cuenta de SAP BTP Cockpit.

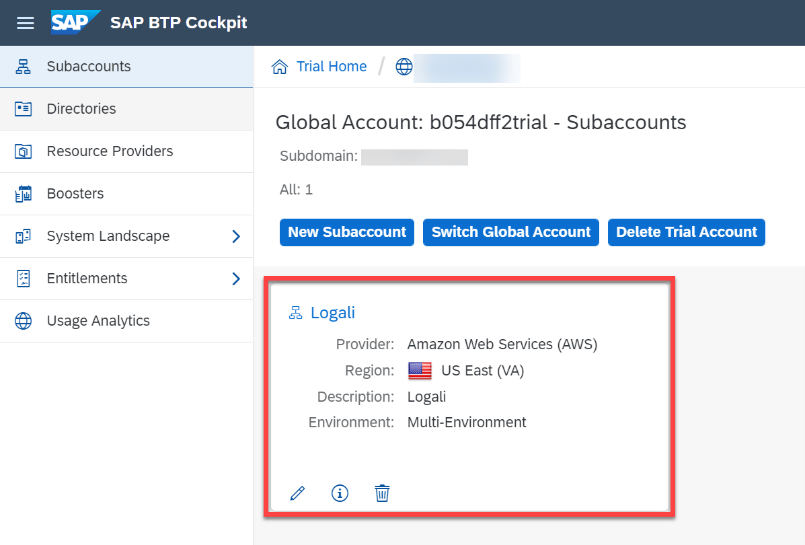

Accedemos a nuestra subcuenta llamada “Logali”.

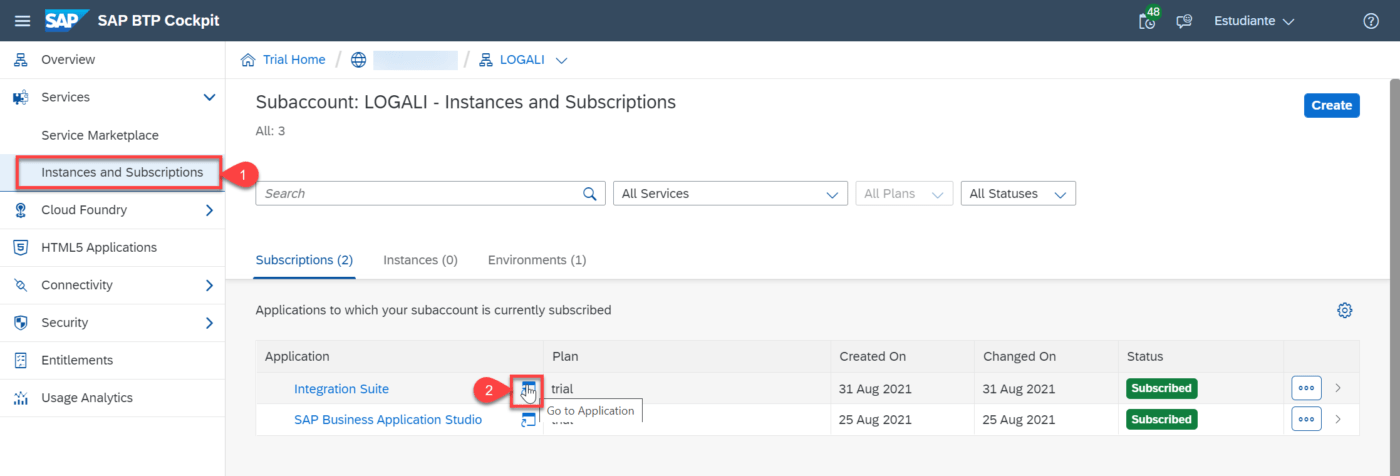

Luego debemos ingresar a Integration Suite.

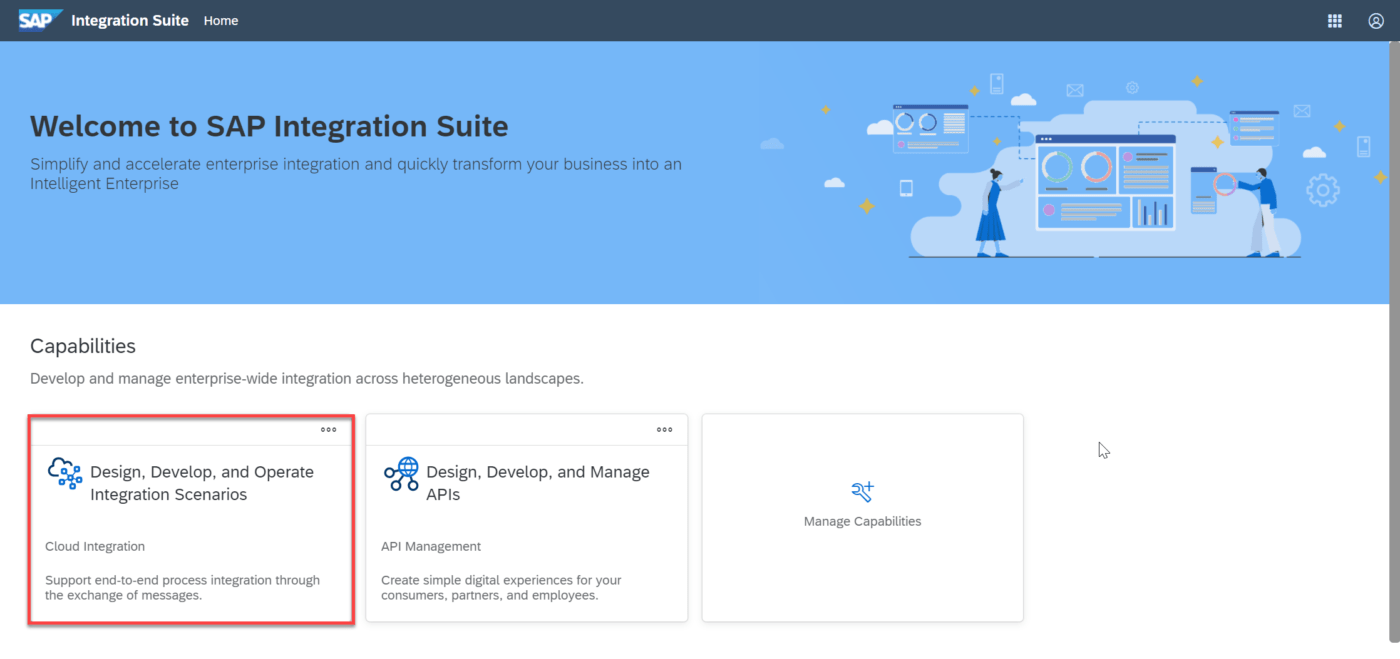

Después debemos ingresar a “Cloud Integration”.

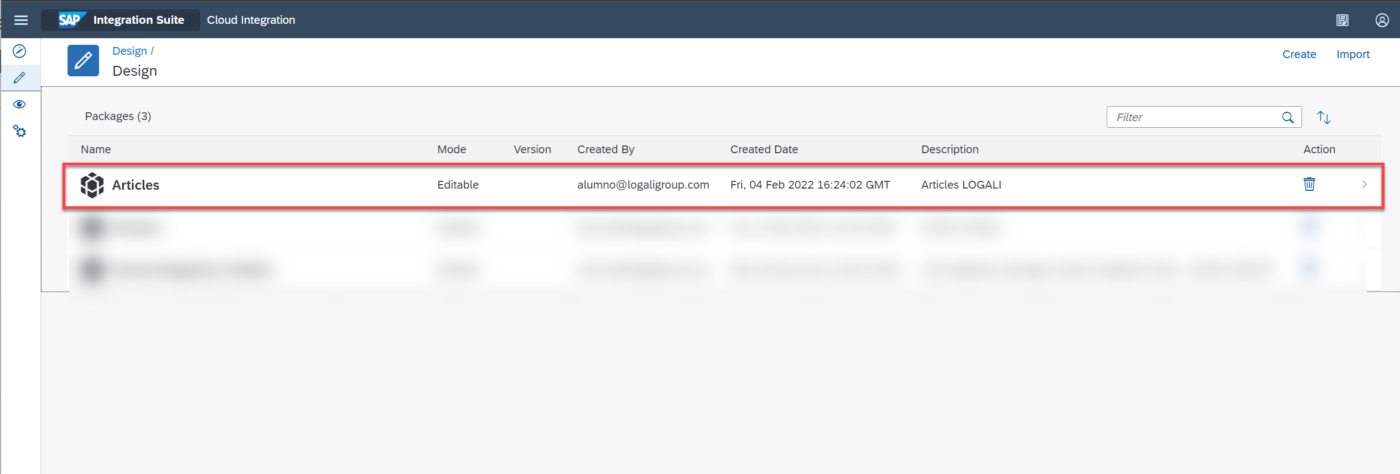

Luego debemos ingresar al apartado de “Design” para poder seleccionar un paquete de integración.

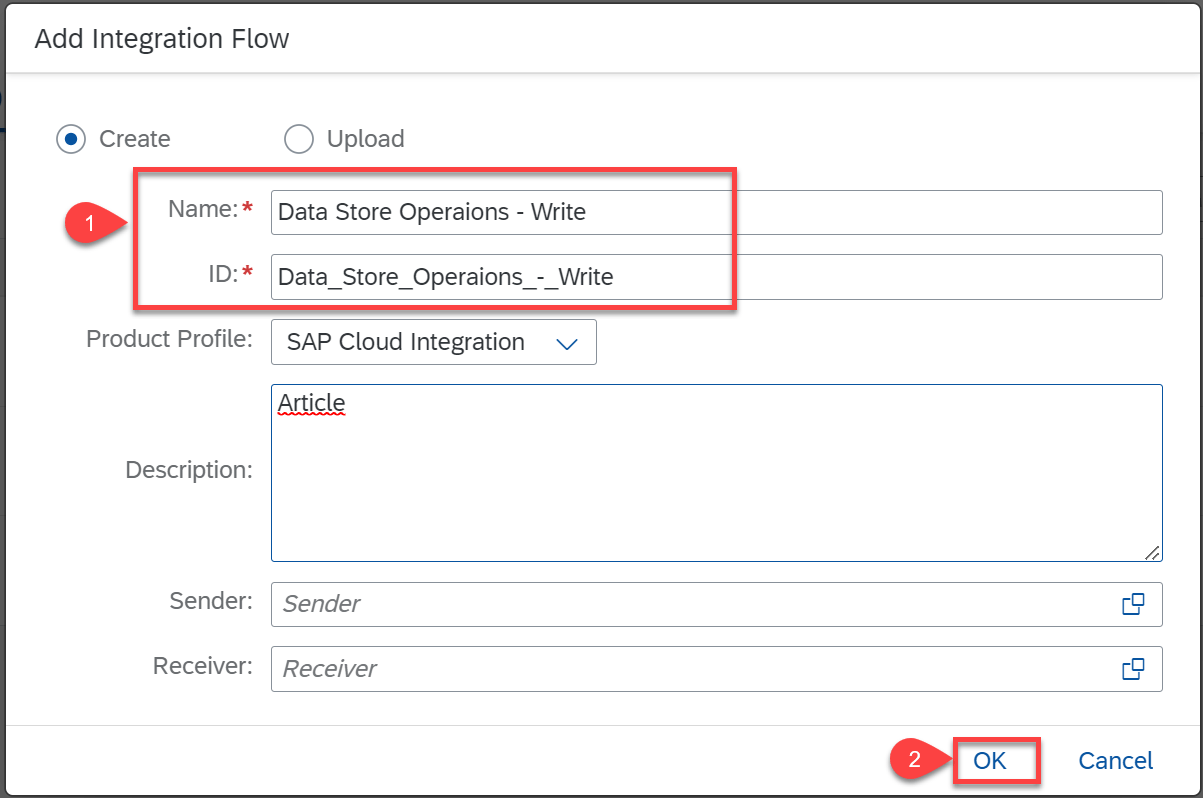

Damos en el botón de edición e ingresamos en la pestaña de “Artifacts” para poder añadir un flujo de integración luego debemos ingresar los datos necesarios para crear el flujo de integración para este caso lo llamaremos “Data Store Operations – Write” y por último dar clic en el botón “Ok”.

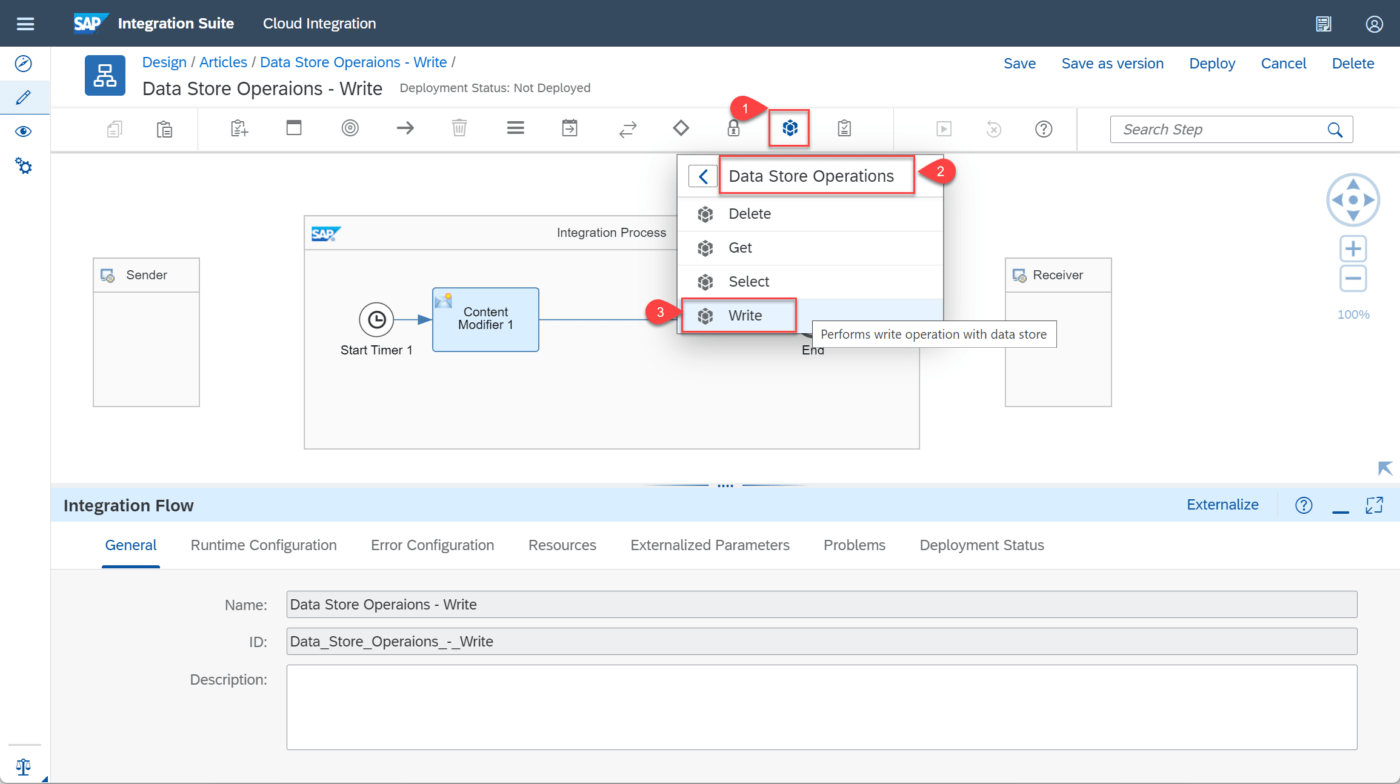

Luego de crear el flujo de integración se debe diseñar la estructura.

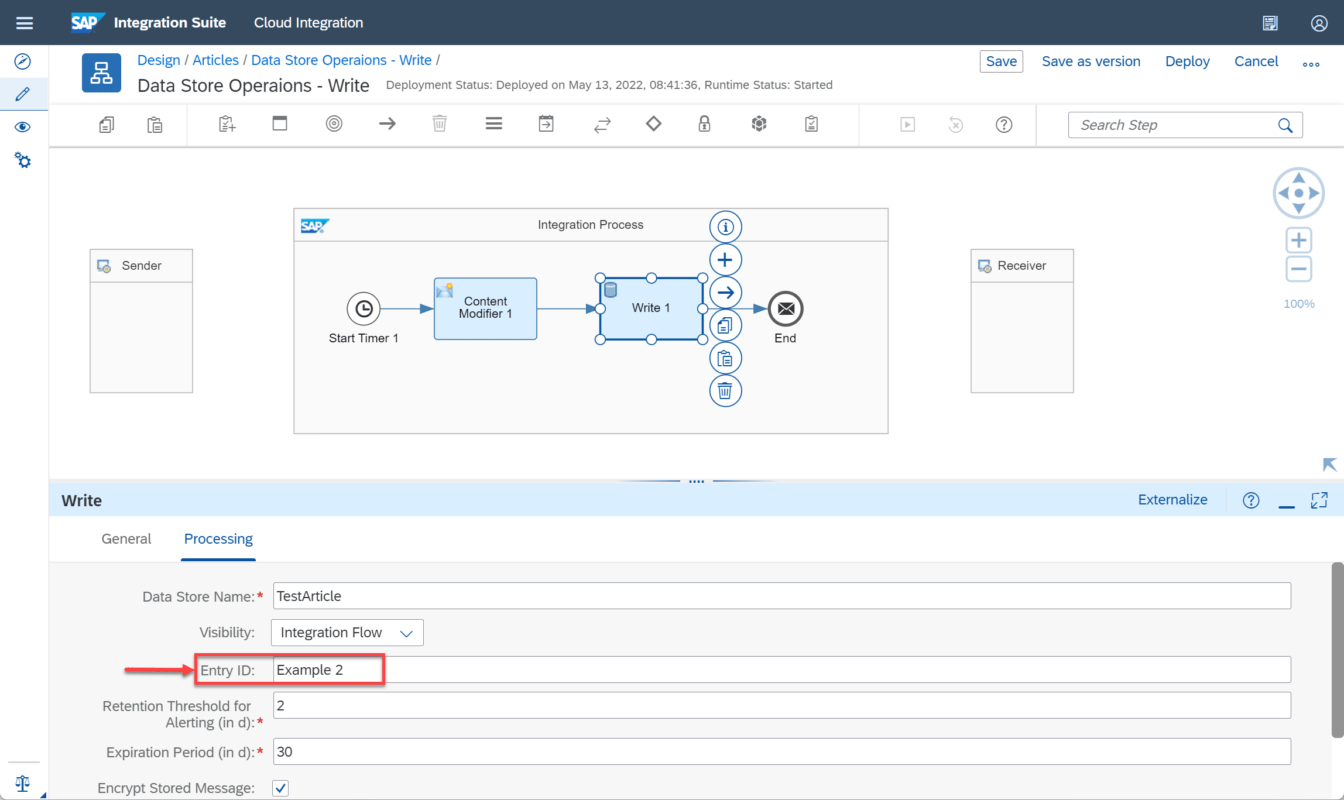

Para este ejercicio vamos a iniciar nuestro flujo enviando un mensaje desde el Content Modifier, el cual luego vamos a pasar al operador Write

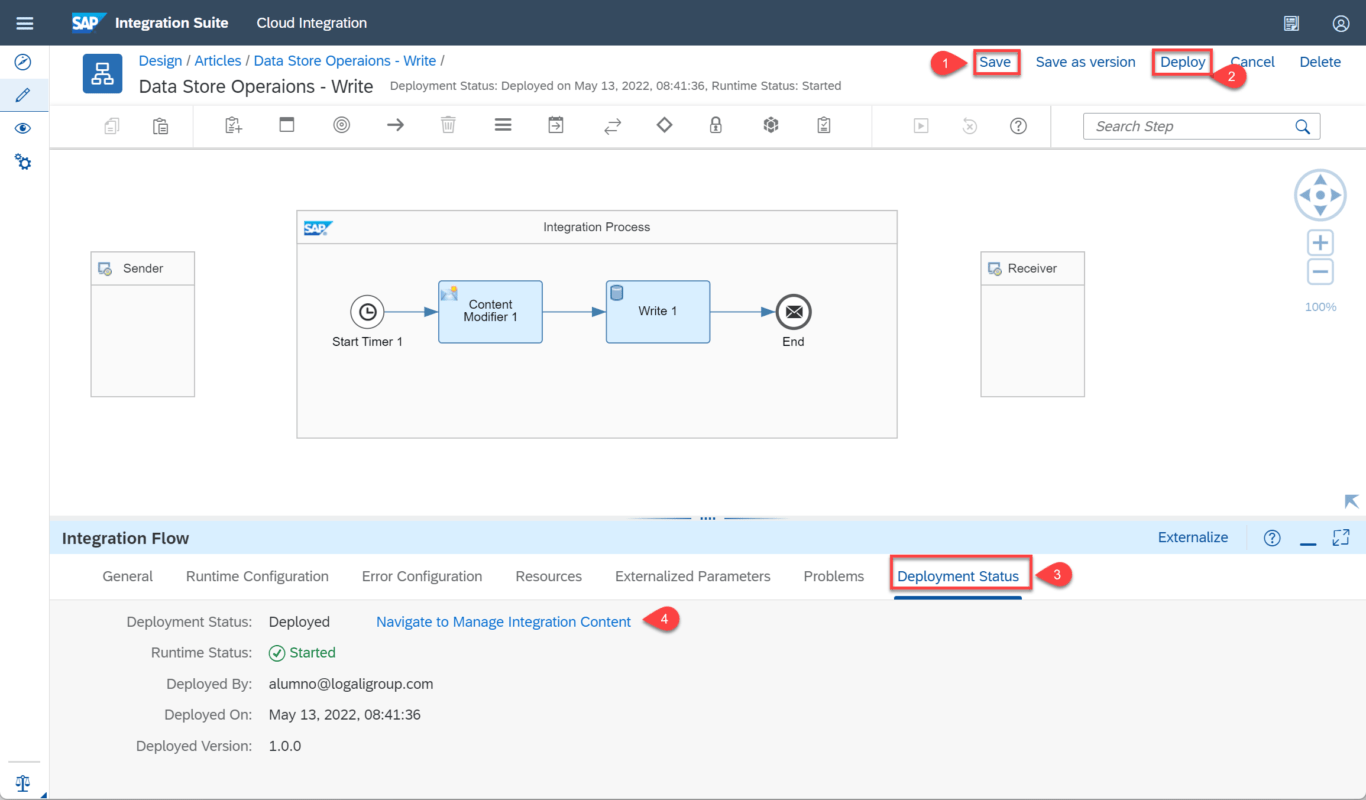

Luego de ingresar a nuestro flujo de integración vamos procedemos a editarlo, en la barra de herramientas seleccionamos el evento “Timer” y lo agregamos a nuestro flujo, y en la pestaña programador (Scheduler), lo vamos a dejar por defecto en ejecutar una vez (Run Once). Vamos a la barra de herramientas y en las transformaciones agregamos Content Modifer y luego en la paleta de persistencia vamos a agregar el elemento Write, quedando de la siguiente forma.

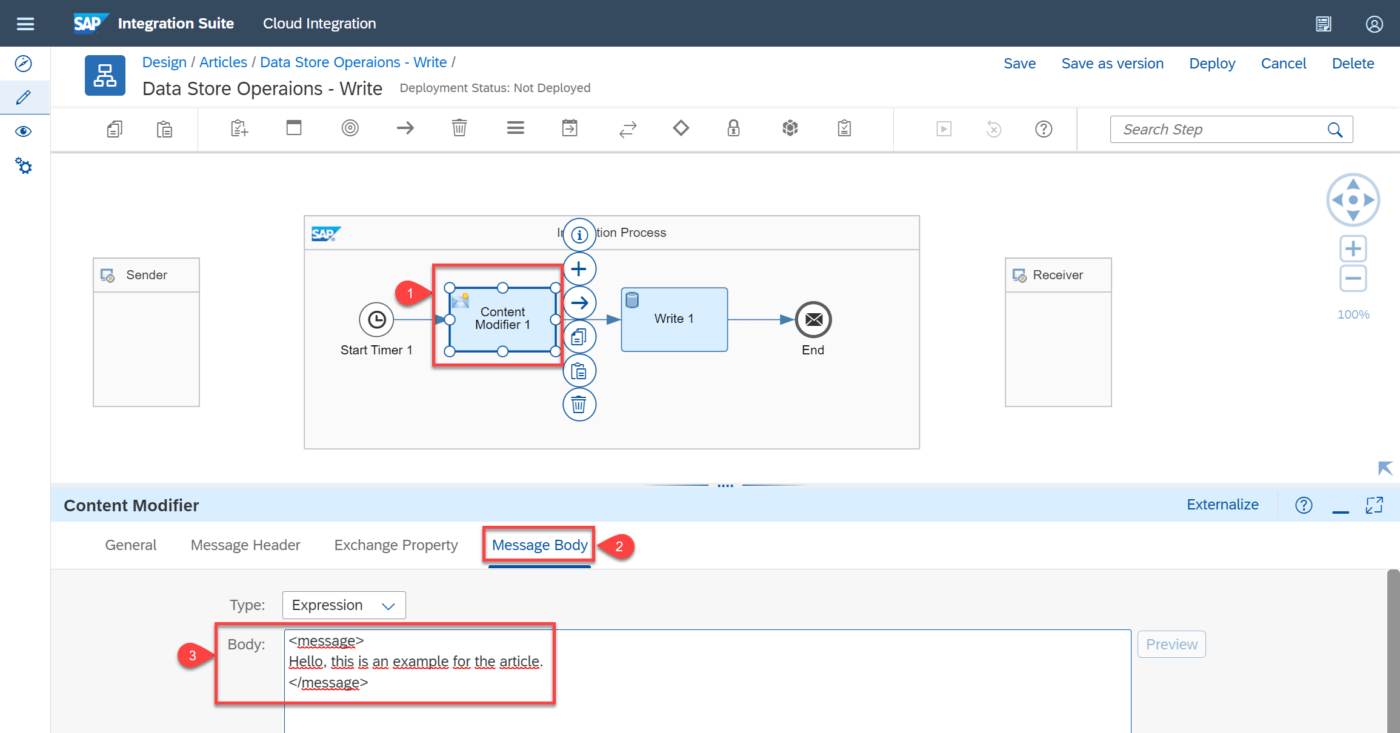

Seleccionamos el Content Modifer para ir a sus propiedades, vamos al cuerpo del mensaje e ingresamos nuestro mensaje en formato XML.

En el elemento Write, encontramos dos pestañas, “General” y “Processing”. Vamos a la pestaña de procesamiento donde encontraremos los siguientes atributos:

Data Store Name: Especificamos el nombre del almacén de datos sin espacios, podemos definir dinámicamente el nombre del almacén de datos con el formato ${header.headername} para leer dinámicamente el nombre desde el encabezado o ${property.porpertyname} para leer el nombre desde una propiedad de intercambio. En este caso ingresaremos el nombre de TestArticle.

Visibility: Aquí definimos si el almacén de datos será visible por todos los flujos de integración “Global” o solo por un flujo de integración en específico “Integration Flows”.

Entry id: En el campo Entry id definimos el identificador que tendrá cada una de las líneas almacenadas en el almacenamiento de datos, tenemos la posibilidad de usar tres variables para hacerlo de forma dinámica:

${header.headername}, ${property.propertyname}, ${xpath.node} para generar dinámicamente el ID de entrada desde una cabecera, propiedad o a partir de un elemento del mensaje indicado por una expresión xPath.

También podemos asignar un valor fijo, este atributo no es obligatorio si no lo indicamos el sistema asignara el mismo del SapDataStoreId.

Nota: El identificador debe ser único, por lo que no pueden existir dos entradas con el mismo identificador en el mismo data store en caso no habilitar la sobreescritura generara un error.

Para este ejercicio asignaremos el ID: Example 1

Retention Threshold for Alerting (in days): En este atributo definimos el tiempo en días que debe pasar para que nos alerten en caso de que no se está usando. En este caso dejamos el valor por defecto que son 2 días

Expiration Period in (days): Es el tiempo que indicaremos cuántos días se mantendrá la información almacenada antes de que sea eliminada o desechada, el tiempo máximo permitido es de 180 días, el tiempo mínimo debe ser por lo menos el doble del atributo anterior. En este caso dejamos el valor por defecto que son 30 días.

Encrypt Stored Message: En esta opción indicamos si queremos que el mensaje sea encriptado en el almacenamiento de datos. Lo dejaremos por defecto.

Overwrite Existing Message: Seleccionamos esta opción si queremos que los mensajes con la misma Entry ID sean sobrescritos, como lo mencionamos anteriormente, no puede haber dos mensajes con el mismo ID. De forma que si usamos el mismo ID, y no marcamos esta opción, solo se escribirá la primera vez. Si marcamos la casilla, se nos guardará solo la última vez.

Para que los mensajes sean sobrescritos, deben tener el mismo ID, por lo que si lo dejamos en blanco la casilla del nombre del ID, nos generará un ID diferente en cada ejecución, por lo evitaremos que se sobrescriban o no se almacenen. Ahora lo dejaremos deshabilitado.

Include Message Headers: Por último, tenemos el atributo que nos permite incluir cabeceras de mensajes además de la carga útil. Ahora lo dejaremos deshabilitado. Debemos tener en cuenta que al almacenar todos los encabezados puede ocupar mucho espacio.

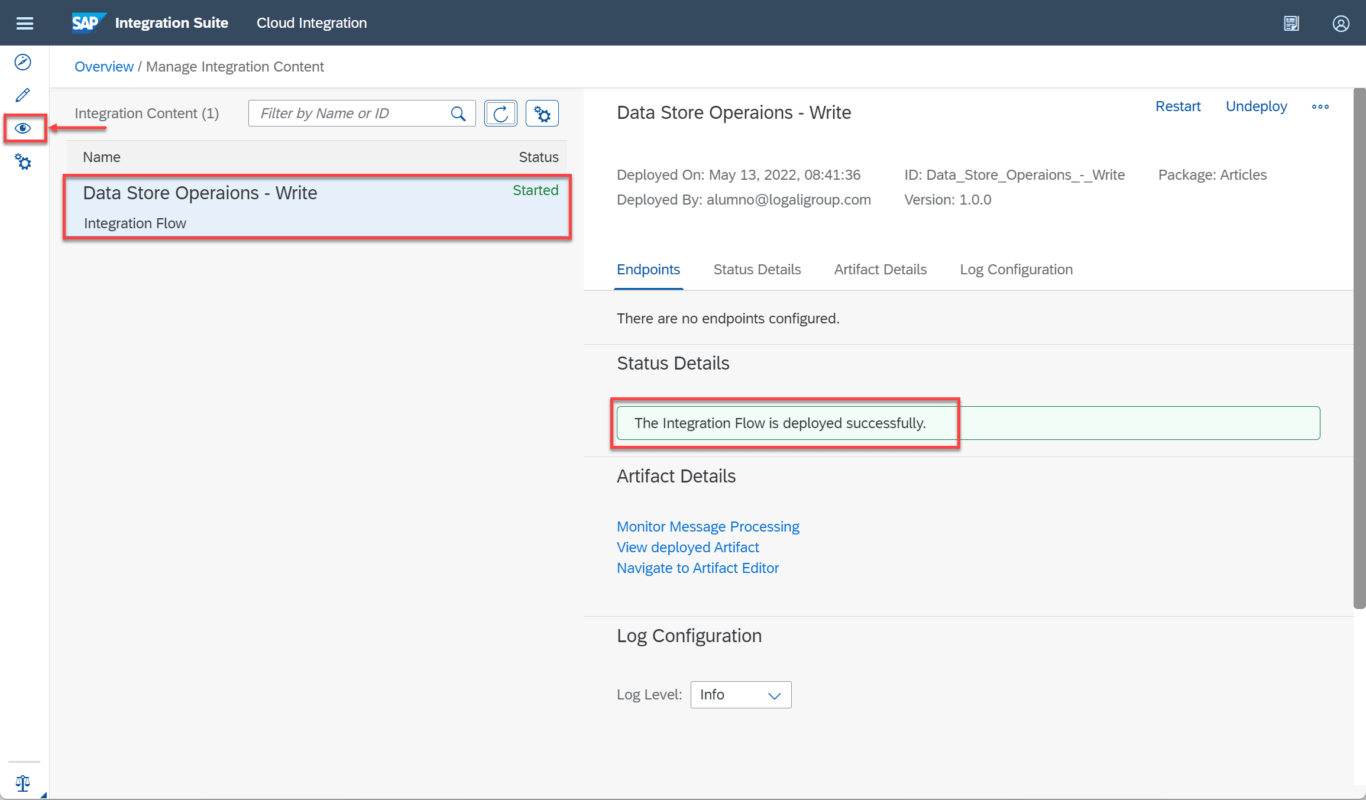

Esto nos llevará a la gestión de contenido de integración donde podremos ver que nuestro flujo de integración se implementó correctamente, luego navegamos por el menú lateral y vamos al monitor.

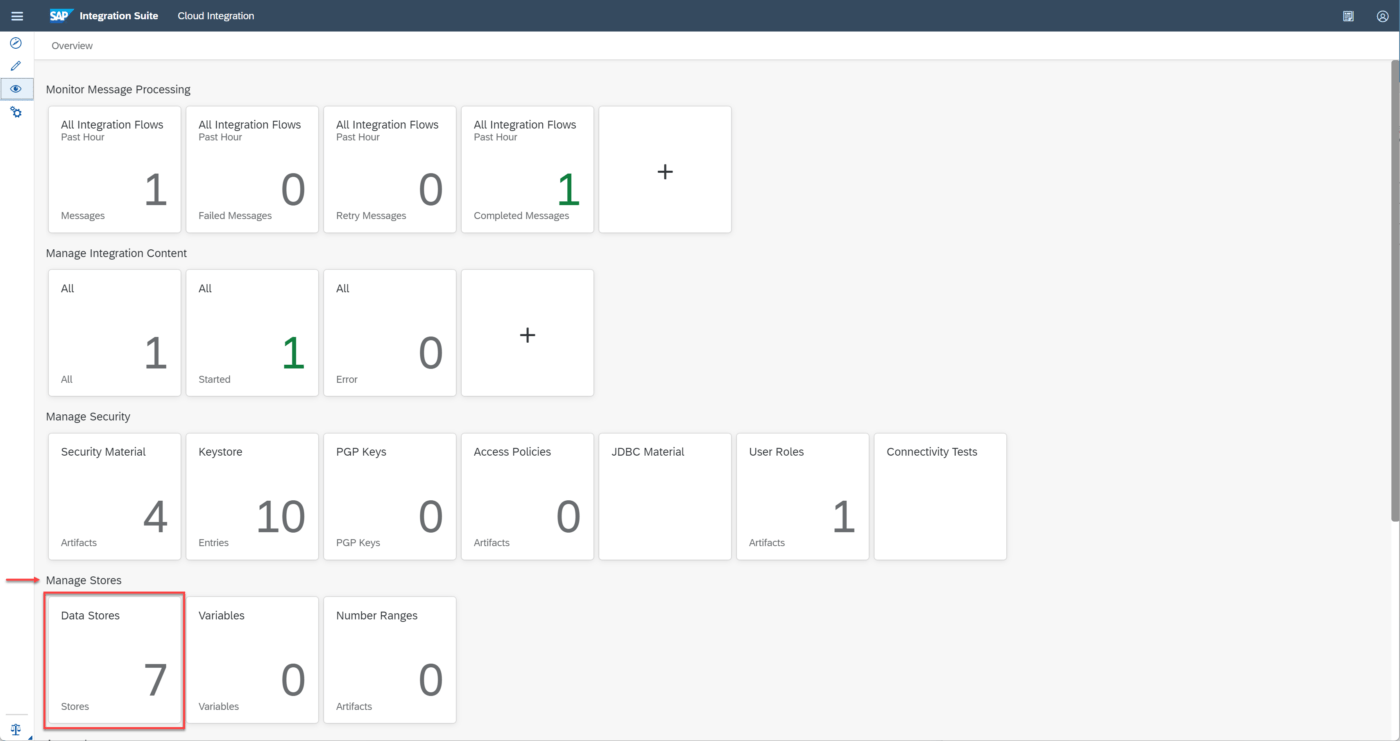

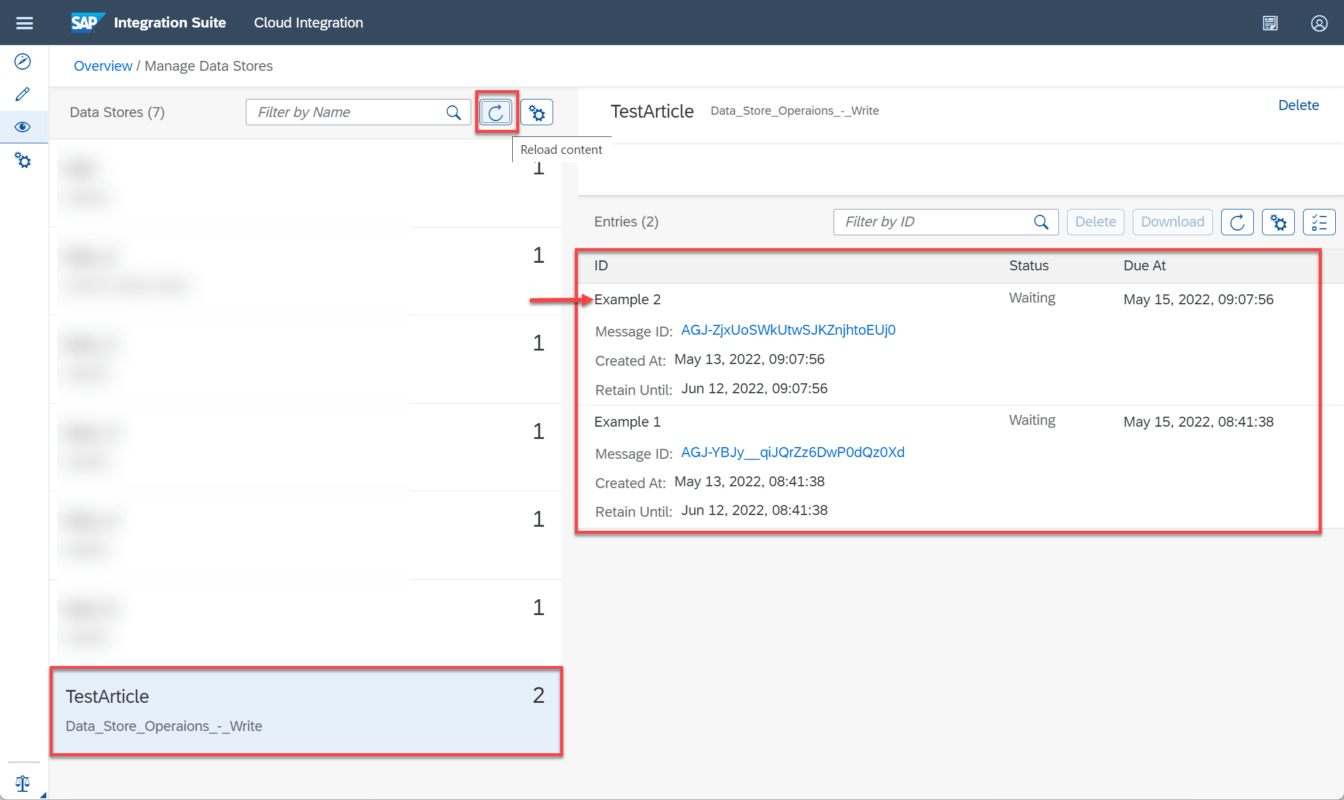

En el monitor vamos al Manage Store e ingresamos al almacenamiento de datos “Data Store”.

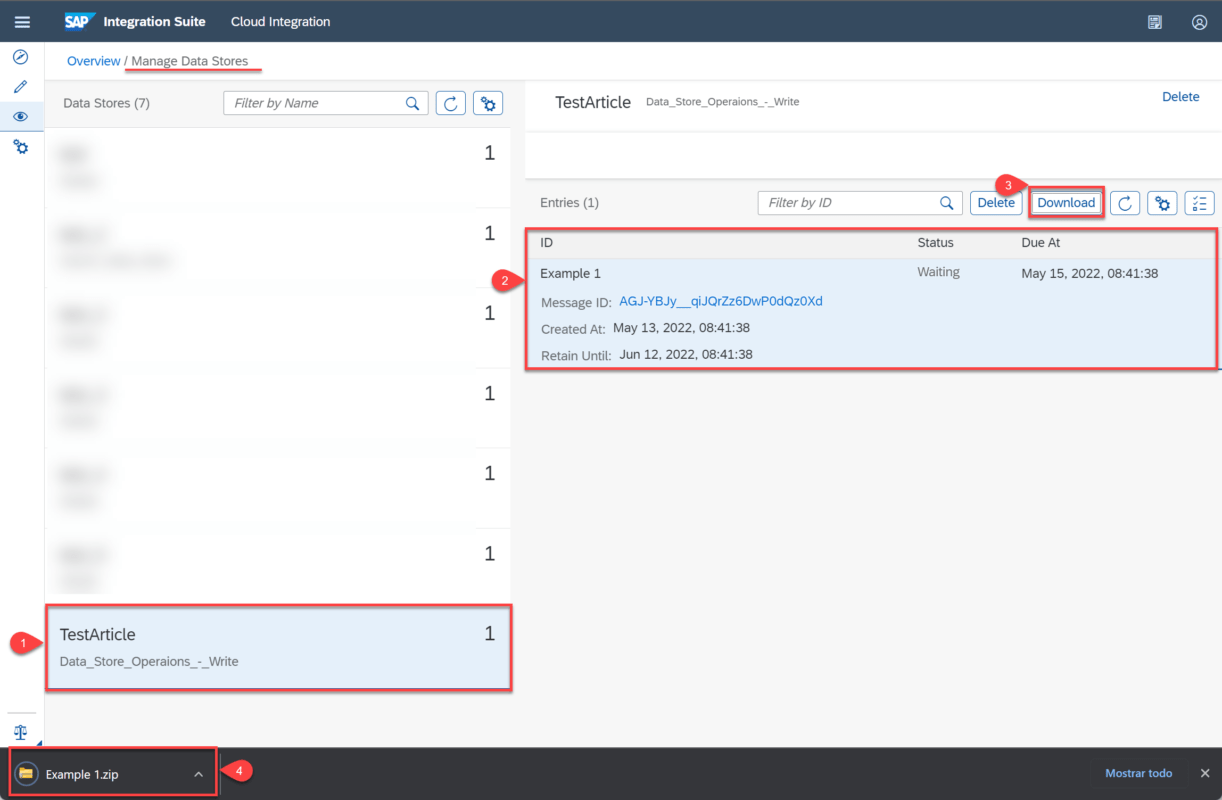

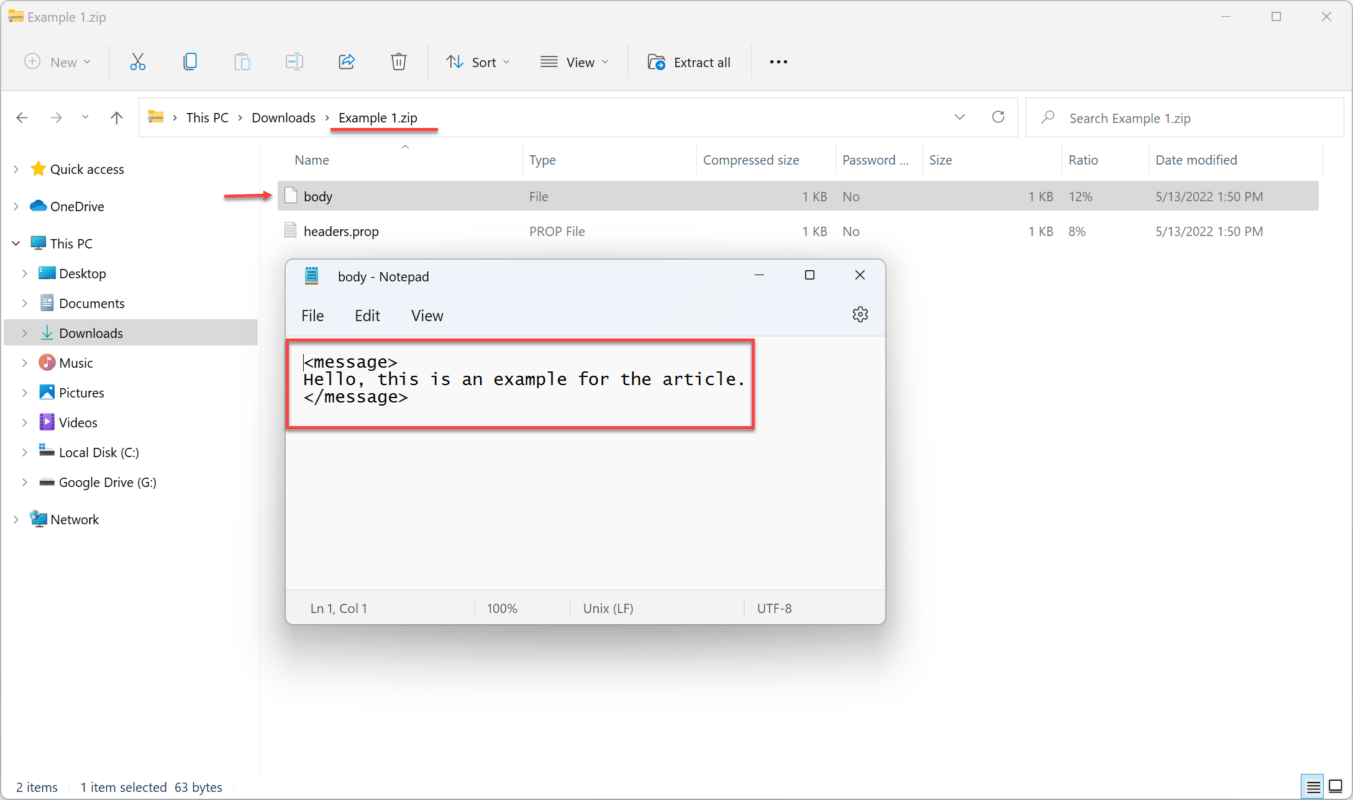

Entramos al almacenamiento de datos y podemos ver que ha creado “TestArticle” y dando clic en el podemos ver el mensaje que hemos enviado con el Id de entrada “Example 1” el cuál podemos seleccionar y descargar.

Una vez descargado podemos verificar el contenido del mensaje almacenado.

Podemos regresar al flujo de integración e ingresar otro Id de entrada para ver que puede seguir almacenando mensajes, en este caso “Example 2”, guardamos e implementamos.

Vamos nuevamente al almacén de datos y como ya el nombre del almacenamiento existe, no crea uno nuevo si no que ingresa un nuevo registro en este.

En este artículo proporcionamos una explicación general de cómo crear un almacenamiento de datos y guardar registros en él. Dirigido a todas las personas que quieran aprender más sobre las herramientas SAP Cloud Integration y como se integran las diferentes herramientas de SAP. Podrás encontrar más datos como estos en los cursos y blogs desarrollados por Logali Group.